Il y a encore peu, la XR (VR/AR/MR) était souvent cantonnée aux POC “waouh”.

Aujourd’hui, elle franchit un cap : elle devient un outil de formation opérationnel, déployable progressivement, et compatible avec des budgets raisonnables.

Ce qui a changé : la XR s’est industrialisée

- Matériel plus simple à déployer : les casques autonomes se généralisent, avec des fonctions de réalité mixte qui facilitent l’acceptation et la prise en main.

- Écosystème plus “standard” : les contenus sont de moins en moins prisonniers d’un constructeur grâce à des standards comme OpenXR.

- Pédagogie outillée : on sait bien concevoir des entraînements procéduraux, avec feedback, répétition, et mesure.

Efficacité : ce que les études et retours terrain indiquent

Plusieurs revues scientifiques et retours d’expérience convergent : la XR est particulièrement pertinente quand il s’agit de :

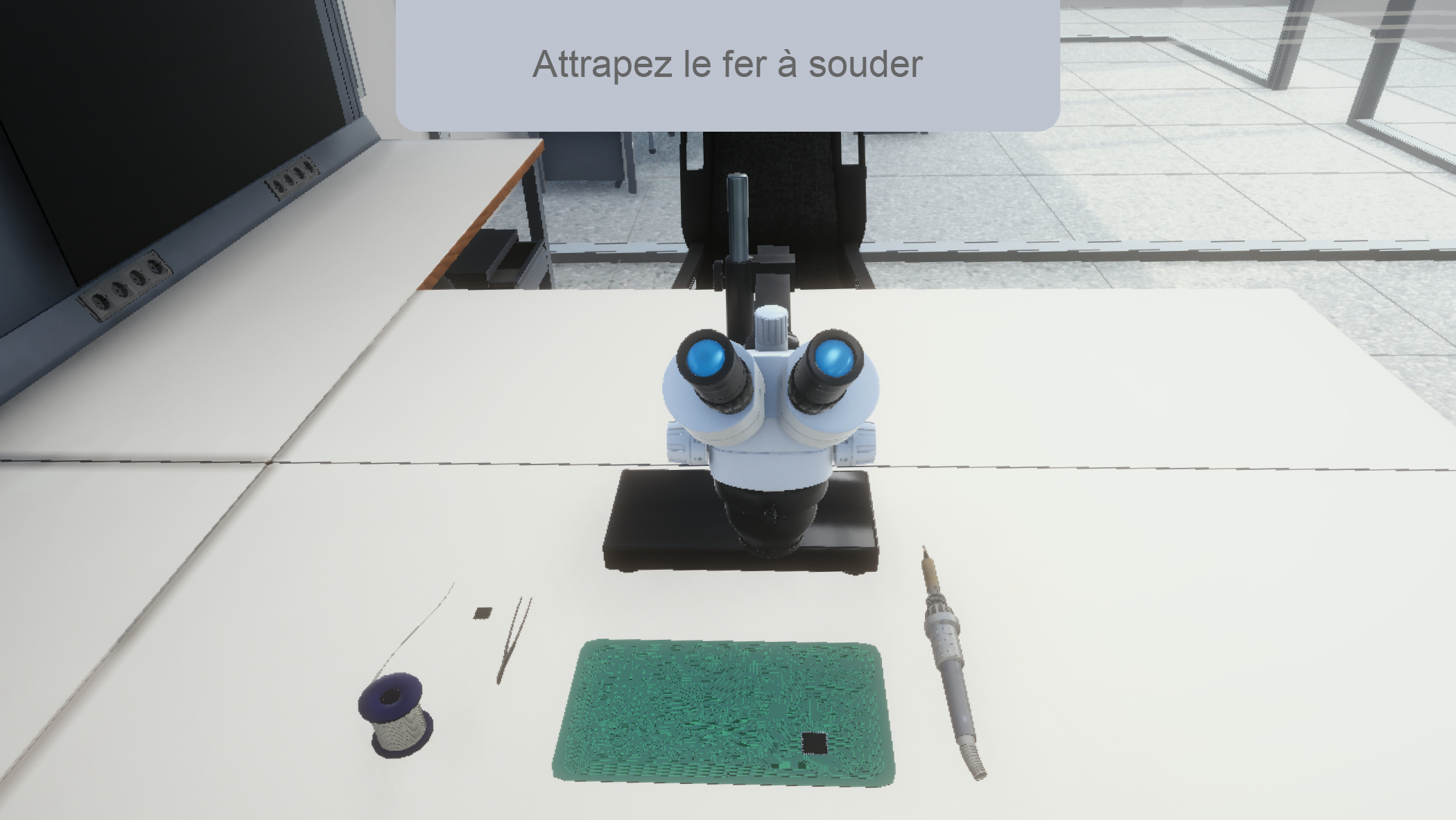

- Former à des gestes procéduraux (séquences, précision, répétition),

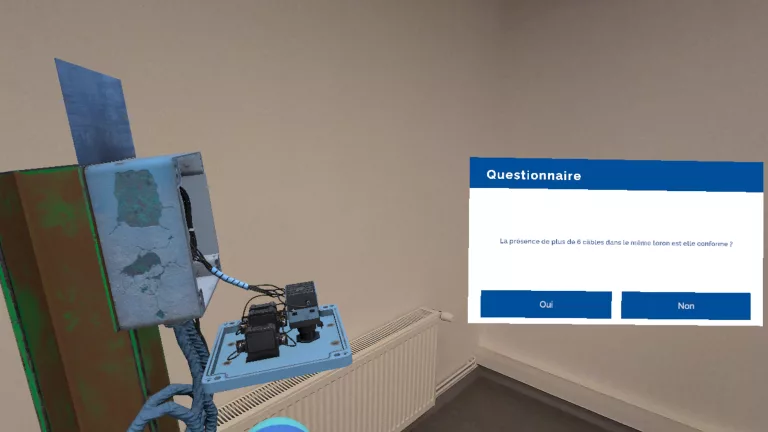

- Réduire les erreurs dans des tâches à risque,

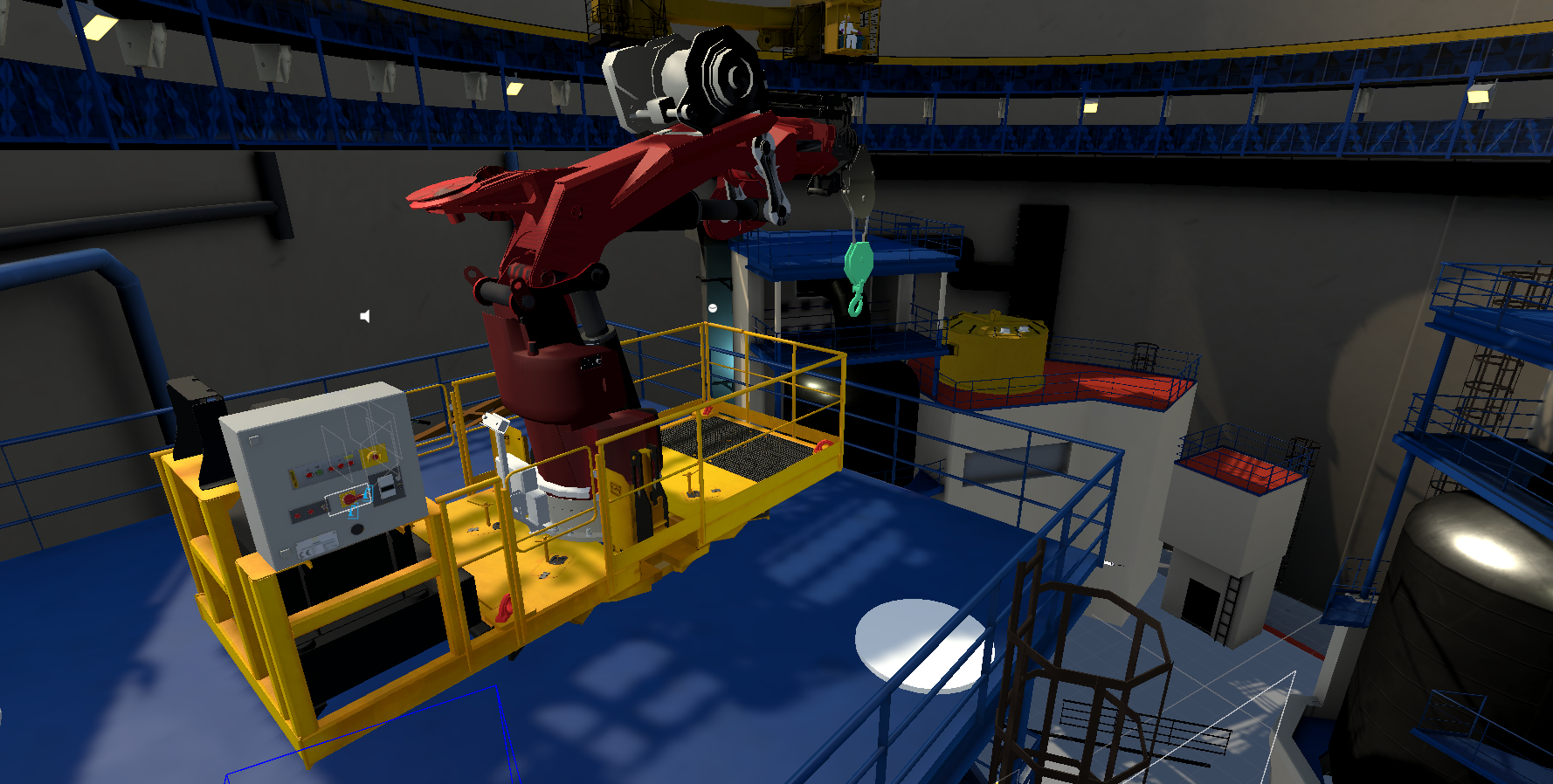

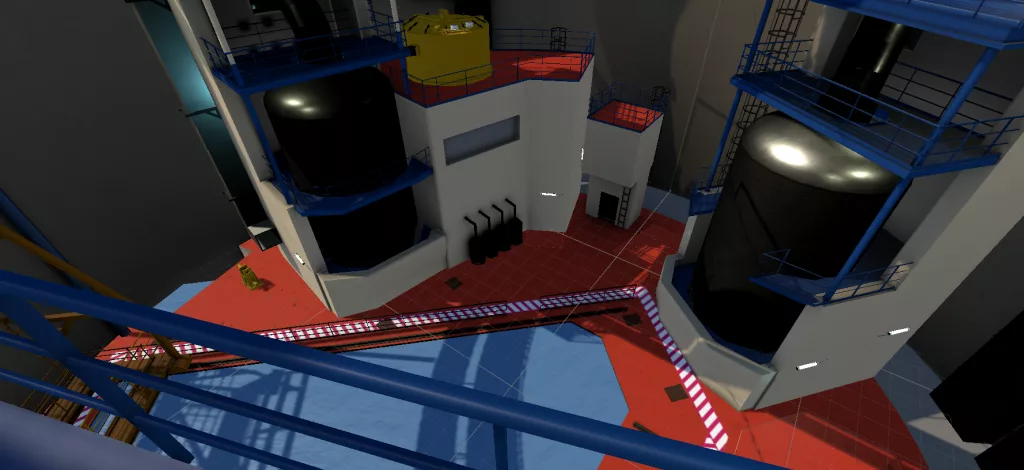

- Accélérer la montée en compétence quand le terrain est coûteux, rare, ou dangereux,

- Standardiser la formation sur plusieurs sites.

L’idée clé : la XR n’est pas “magique” mais quand le cas d’usage est bien choisi et bien scénarisé, les gains sont très concrets.

“Petit budget” : l’approche qui change tout

Plutôt que viser “la machine complète” dès le départ, on peut avancer par paliers !

On commencer par un geste métier à fort enjeu (sécurité, qualité, coût de non-qualité, turnover…), puis enrichir progressivement :

Étape 1 — Le geste critique (quick win)

Une micro-simulation courte, avec feedback, scoring, et répétition illimitée.

Étape 2 — La séquence

On ajoute les variantes terrain, les erreurs fréquentes et les situations dégradées.

Étape 3 — La machine complète

On assemble les briques : procédure complète, diagnostic, maintenance, scénarios rares.

Cette progression a un avantage majeur : chacun investit à son rythme, et chaque étape produit de la valeur.

Check-list : un cas d’usage “XR-ready” ?

Si vous répondez “oui” à au moins 2 questions, vous tenez probablement un bon sujet :

- Le geste/procédure est-il critique (qualité, sécurité, coûts) ?

- La formation terrain est-elle rare, chère, risquée ou hétérogène ?

- Les erreurs sont-elles fréquentes ou coûteuses ?

- Peut-on mesurer la performance (temps, erreurs, conformité) ?

- Une répétition guidée améliorerait-elle la maîtrise ?

Pour aller plus loin

Revue systématique sur l’entraînement procédural en VR

Revue sur les caractéristiques VR et leurs liens avec les résultats d’apprentissage

Étude sur formation VR vs formation tutorée en contexte d’assemblage

Industrie : baisse d’erreurs et gain de temps avec AR guidée en assemblage

Exemple corporate : amélioration des scores et de la rétention via VR en formation